Wenn „privat“ nicht privat bleibt – ein Weckruf für ChatGPT-Nutzer

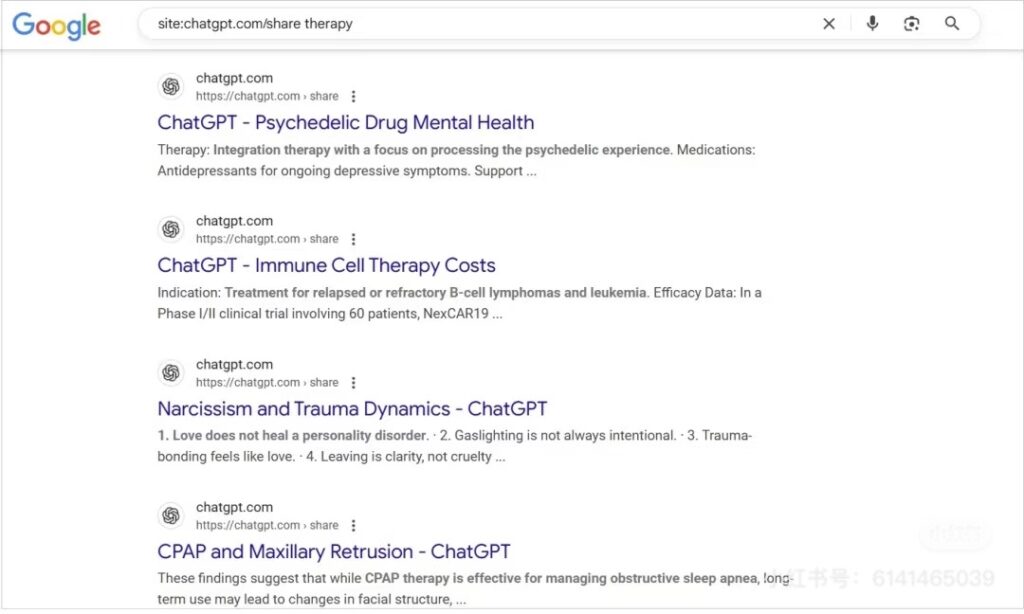

Im August 2025 sorgte ein Bericht von Heise für Aufsehen: Private ChatGPT-Chats, die über die Funktion „Diesen Chat auffindbar machen“ freigegeben wurden, tauchten plötzlich im Google-Index auf.

Ergebnis: Rund 4.500 Gespräche waren öffentlich sichtbar – darunter etliche mit sensiblen Geschäftsdaten und persönlichen Informationen.

OpenAI hat die Freigabefunktion inzwischen entfernt und arbeitet gemeinsam mit Suchmaschinen daran, die Inhalte wieder aus den Ergebnislisten zu löschen.

Für kleine und mittelständische Unternehmen in Deutschland, Österreich und der Schweiz ist das mehr als eine Randnotiz. Es ist ein deutlicher Hinweis darauf, wie schnell ein bequemes KI-Feature zu einem ernsthaften DSGVO-Risiko werden kann.

Warum das für den Mittelstand in der DACH-Region relevant ist

KI-Tools wie ChatGPT sind heute aus dem Arbeitsalltag vieler Teams nicht mehr wegzudenken – sei es für schnelle Textentwürfe, Meeting-Zusammenfassungen oder kreative Ideenfindung.

Doch wo KI im Spiel ist, sind auch Daten im Spiel. Und in einem Umfeld, in dem Datenschutzgesetze strenger sind als fast überall sonst auf der Welt, kann ein einzelner Vorfall erhebliche Folgen haben: Bußgelder, Vertrauensverlust, Imageschaden.

Vier Wege, wie ChatGPT-Daten öffentlich werden können

Selbst wenn die Plattform Schutzmechanismen bietet, gibt es potenzielle Schwachstellen:

- Technische Fehler – Bugs oder Serverprobleme, die zwischengespeicherte Daten freigeben

- Modellverhalten – seltene Fälle, in denen das System frühere Eingaben erneut ausgibt

- Drittanbieter-Integrationen – Daten werden über externe Systeme geleitet

- Menschliche Unachtsamkeit – vertrauliche Informationen werden unbedacht eingegeben

In der Praxis sind es vor allem Punkt 3 und 4, die KMUs zum Verhängnis werden – und genau hier lassen sich mit klaren Prozessen und passender Technik große Risiken vermeiden.

Das Compliance-Risiko im Klartext

Schon ein einziger Datensatz mit Kundeninformationen, der nach außen gelangt, kann Folgendes auslösen:

- Meldung an die Datenschutzbehörde

- Hohe DSGVO-Strafen

- Vertrauensverlust bei Kunden und Partnern

Wer jetzt in Prävention investiert, spart später oft ein Vielfaches an Zeit, Geld und Nerven.

Wie MDR-Services Risiken entschärfen

Managed Detection and Response ist mehr als eine technische Lösung – es ist euer Frühwarnsystem und Sicherheitsnetz in einem.

MDR-Services helfen KMUs, KI-Anwendungen wie ChatGPT sicher einzusetzen, indem sie:

- Datenströme in Echtzeit überwachen und riskante Übertragungen blockieren

- Vertrauliche Informationen automatisch filtern, bevor sie das Unternehmen verlassen

- KI-Nutzungsrichtlinien durchsetzen – auch wenn Mitarbeitende diese umgehen wollen

- Im Ernstfall sofort handeln, um Lecks einzudämmen und Ursachen zu analysieren

So bleibt KI ein Produktivitäts-Boost – ohne böse Überraschungen bei der Compliance.

Fünf Sofortmaßnahmen für sichere ChatGPT-Nutzung

- Keine sensiblen oder personenbezogenen Daten in KI-Chats eingeben

- ChatGPT nur für nicht-kritische Aufgaben nutzen

- Mitarbeitende regelmäßig zu KI-Sicherheit und Datenschutz schulen

- In den ChatGPT-Einstellungen „Chatverlauf & Training“ deaktivieren

- Möglichst auf EU-gehostete KI-Lösungen setzen

📌 Tipp: Unser DSGVO-Leitfaden für KMUs bietet noch mehr konkrete Handlungsempfehlungen. For more compliance tips, visit our DSGVO compliance guide for SMEs.

Sicherheitskultur statt Einzelmaßnahmen

Technische Lösungen sind wichtig – aber sie wirken nur, wenn die Unternehmenskultur mitzieht.

Dazu gehören:

- Regelmäßige Kontrolle der KI-Nutzungsprotokolle

- Benennung eines festen Ansprechpartners für KI-Sicherheit oder MDR

- Quartalsweise Schulungen zu aktuellen Bedrohungen und Compliance-Anforderungen

- IT-Abstimmung vor jeder neuen KI-Integration

Unternehmen, die MDR-Services mit einer gelebten Sicherheitskultur verbinden, machen KI zu einem Wettbewerbsvorteil – nicht zu einem Einfallstor.

FAQ – Häufige Fragen von KMUs

Ist ChatGPT DSGVO-konform?

Ja, sofern es korrekt eingesetzt wird. Die Verantwortung für eingegebene Inhalte liegt beim Nutzer.

Speichert ChatGPT meine Daten?

Ja, es sei denn, die Speicherung wird aktiv deaktiviert.

Wie hilft MDR konkret?

Durch laufende Überwachung, Richtliniendurchsetzung und schnelles Eingreifen bei Auffälligkeiten.

Was tun bei einem Verdacht auf Datenleck?

Nutzung sofort stoppen, MDR-Partner informieren, Konten sichern und prüfen, ob eine Meldung an die Behörde nötig ist.

Fazit

Der Fall der öffentlich indexierten ChatGPT-Chats zeigt deutlich: „Privat“ ist im Netz nicht immer privat.

Für KMUs in der DACH-Region heißt das: jetzt handeln, statt später Schadensbegrenzung betreiben.

Unsere Empfehlung: Kombinieren Sie klare interne Regeln mit MDR-Services und einer aktiven Sicherheitskultur – so holen Sie das Beste aus KI heraus, ohne Ihre Compliance zu gefährden.